AIがどうしてその答えを出したのか、人間が理解できるように説明できるAIのこと

簡単な説明

説明可能なAIってのは、「AIがなんでそう答えたの?」ってのをちゃんと説明してくれるAIのこと。

いきなり「この人は不合格です!」って言われても困るけど、理由がわかれば納得できるでしょ?

だから、AIの“考え方”を見える化してくれる便利な仕組みってわけ!

由来

近年、AI(特にディープラーニング)はとても高い精度で画像認識や言語理解を行えるようになりました。しかし、その判断の「根拠」がわからないという問題が出てきました。

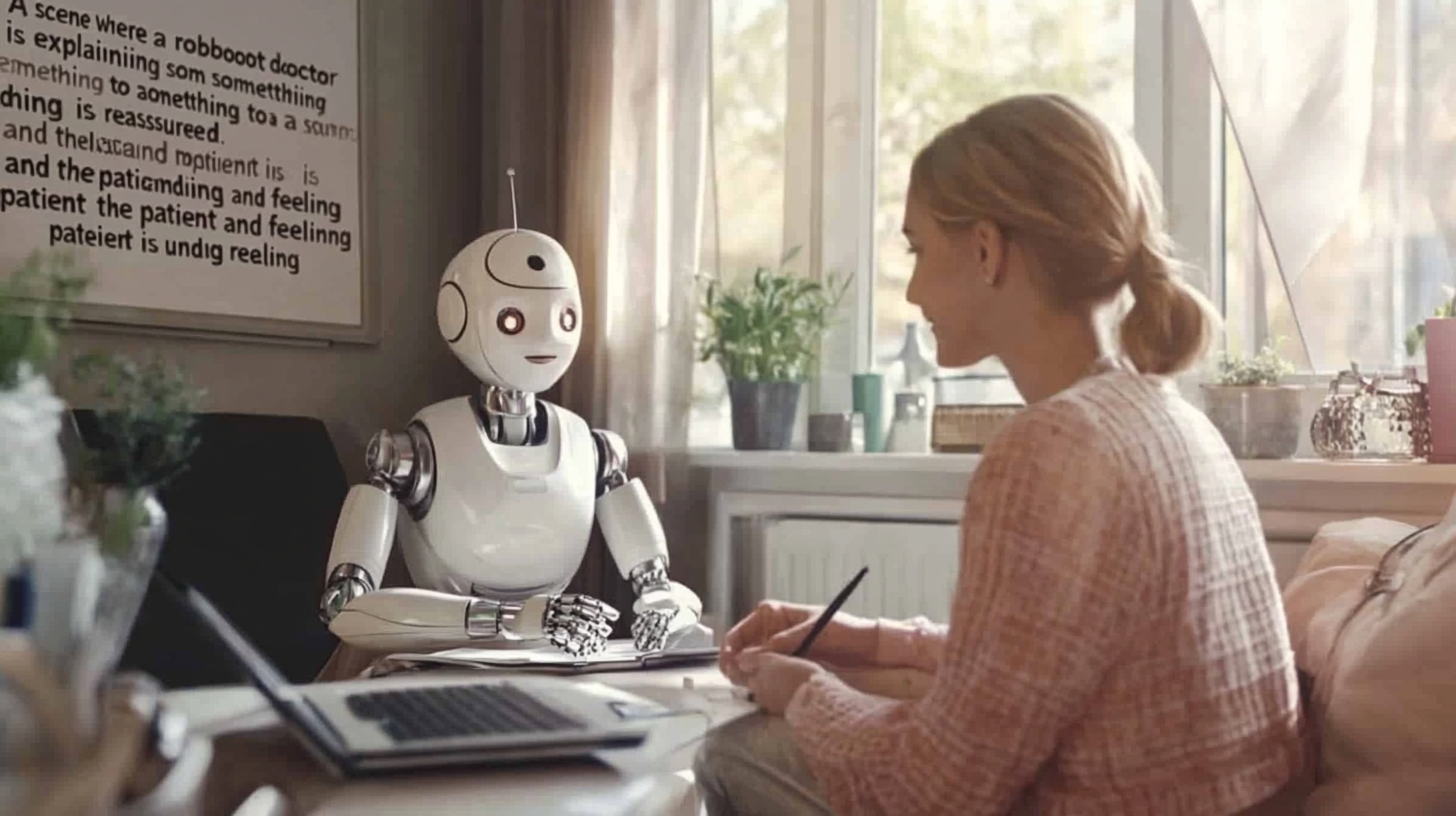

たとえば、あるAIが「この人は病気です」と診断しても、なぜそう判断したのかが説明できなければ、医師も患者も納得できません。

そのため、AIが出した結論の理由を説明できるようにする技術、「説明可能なAI(XAI)」が注目されるようになりました。

具体的な説明

「説明可能なAI」とは、AIが出した判断や予測の根拠を人が理解できるようにする技術や考え方のことです。

これにより、AIを使う人がその判断を信用しやすくなり、間違いがあっても修正しやすくなります。

たとえば、AIが「この写真には猫が写っている」と判断したとします。

説明可能なAIでは、「この耳の形やヒゲのパターンから猫だと判断した」と説明できるようにします。

これにより、AIの判断が正しいかどうかを人が検証できるようになります。

説明可能なAIは、ブラックボックスになりがちなディープラーニングモデル(たとえばCNNやRNN)を対象に、ローカルな特徴量の重要度(SHAP値、LIMEなど)を解析し、入力と出力の因果関係を人間が理解できる形に翻訳する手法です。

医療、金融、司法など、AIの判断の正当性が問われる分野で特に重要視されています。

例文

「このAIが合格と判定した理由は、説明可能なAIのおかげで“テストの点数が85点で、出席率が95%だったから”とわかります。」

疑問

Q: なぜAIの説明が必要なのですか?

A: 人がAIの判断を信頼するためには、その理由がわからないと不安だからです。特に医療や金融では重要です。

Q: 説明可能なAIは、普通のAIと何が違うのですか?

A: 普通のAIは結果だけ出しますが、説明可能なAIは「どうしてその結果になったか」も示してくれます。

Q: 説明可能なAIの技術にはどんなものがありますか?

A: LIME、SHAP、Counterfactuals(反事実説明)などがあります。

Q: なぜディープラーニングは説明が難しいのですか?

A: ニューラルネットワークの中間処理は非常に複雑で、人間が直感的に理解できる形ではないからです。

理解度を確認する問題

説明可能なAIに関する記述として最も適切なものはどれか?

A. AIの処理速度を向上させる技術のこと

B. AIの判断にかかわるプログラムコードを暗号化する技術のこと

C. AIが行った判断の根拠を人が理解できるようにする技術のこと

D. AIの処理結果を自動的に削除する技術のこと

正解:C

関連論文や参考URL

“Why Should I Trust You?” Explaining the Predictions of Any Classifier(2016, Ribeiro et al.)

概要:LIMEという説明技術を紹介し、AIモデルのブラックボックス問題に対処

結果:ユーザーはAIの判断を視覚的に理解できるようになり、信頼性が向上したと結論

まとめ

説明可能なAI(XAI)とは、AIの判断理由を人間が理解できるようにする技術です。

ブラックボックス型のAIと違い、「なぜそう判断したか」が説明できます。

これにより、医療・金融などで安心してAIを活用できるようになります。

コメント